A Advanced Micro Devices (AMD) decidiu abandonar a marca ATI que batiza as suas placas de vídeo para computadores, segundo reporta o site Mashable. A decisão foi tomada após uma pesquisa de mercado que apontou que os nomes Radeon e FirePro (que nomeia algumas placas-mãe de alto desempenho), em combinação com a marca AMD são mais reconhecidos pelos consumidores.

A mudança não afetará os modelos disponíveis atualmente no mercado, porém a partir dos novos modelos a marca ATI não vai ilustrar mais as caixas dos componentes. Segundo o site, a marca "AMD Radeon" ou "AMD FirePro" vão entrar em uma campanha de marketing para explicar ao público a mudança.

Negócio bilionário

A AMD comprou a ATI em 2006 pelo valor de US$ 5,4 bilhões em 2006, um dos maiores negócios fechados no mundo de tecnologia. Na ocasião a ATI foi renomeada internamente para AMD Graphics Product Group, mas a marca ATI era muito forte no mercado devido a competição com a Nvidia. A ATI foi a marca responsável pelos componentes gráficos do GameCube da Nintendo e Xbox 360 da Microsoft.

Mostrando postagens com marcador técnologia. Mostrar todas as postagens

Mostrando postagens com marcador técnologia. Mostrar todas as postagens

segunda-feira, 30 de agosto de 2010

domingo, 25 de julho de 2010

Empresa apresenta a primeira tela à prova de marteladas

Em um momento de distração, um esbarrão na mesa joga aquele smartphone topo de linha – e recém-adquirido – ao chão, com a tela voltada para baixo. Isso, naturalmente, acontece no dia em que a faxina está acontecendo e, portanto, o tapete que sempre estaria ali se encontra pendurado na janela para tomar sol. Resultado: tela trincada e visita agendada à assistência técnica.

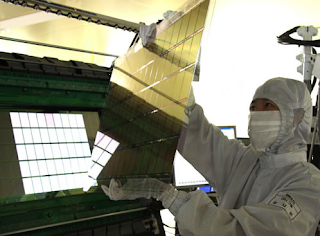

Pensando em evitar justamente essa parada para manutenção, a Samsung está desenvolvendo um novo processo de fabricação de telas AMOLED. Praticamente inquebráveis, flexíveis e seguros, estes dispositivos devem começar a aparecer em equipamentos de consumo a partir de 2012.

A tecnologia envolvida nas novas telas da Samsung é relativamente simples. Os pesquisadores da companhia trocaram algumas das variedades de plástico utilizadas na composição da tela depositando o TFT (“thin film transistor” – transistor em filmes finos) –, responsável pela geração da luz que forma as imagens –, sobre polyimide (PI), ao invés da proteção de vinil utilizada atualmente.

Trocar os materiais de um produto quase sempre resulta em um novo conjunto de características no artefato pronto. No caso da tela AMOLED da Samsung, a resistência a choques é apenas uma das vantagens obtidas com o uso da polyimide.

A maior flexibilidade do conjunto – mesmo durante o funcionamento – é outro ganho significativo das novas telas, e possibilitam o desenvolvimento de gadgets ainda mais inovadores. Formatos diferenciados e até mesmo a mudança de conformação passam a ser possíveis com displays não rígidos.

Além disso, o composto utilizado também favorece a visualização da tela, por permitir a melhor transmissão da luz gerada no painel TFT. Assim, todo o potencial do AMOLED – maior contraste, melhor reprodução de cores e a independência de iluminação traseira – passa a ser utilizado.

O digitalizador – componente responsável pela sensibilidade ao toque – acoplado às telas é colocado sobre a área visível, para permitir o reconhecimento do contato de canetas ou dedos. No vídeo de demonstração e no material escrito a respeito da nova tecnologia, a Samsung não revela se a tela exibida já tem o digitalizador, ou se é apenas o equipamento de formação de imagem.

Pela posição do equipamento de sensibilidade, de nada adianta a tela da Samsung ser inquebrável, se ao menor impacto o funcionamento da touchscreen for comprometido.

Segundo especialistas da indústria – como informa o site coreano etnews –, “a tecnologia da SMD (Samsung Mobile Displays, divisão de telas para portáteis da empresa) avança mais rapidamente do que esperado. Isso torna ainda mais urgente a necessidade da empresa em alcançar preços competitivos para produção em massa a partir de 2012”.

Ou seja, ainda que não seja um lançamento, a tecnologia da tela flexível, leve e inquebrável estará em breve nas mãos dos consumidores.

Agora veja o video abaixo e veja como vai ser os monitores à prova de marteladas

Pensando em evitar justamente essa parada para manutenção, a Samsung está desenvolvendo um novo processo de fabricação de telas AMOLED. Praticamente inquebráveis, flexíveis e seguros, estes dispositivos devem começar a aparecer em equipamentos de consumo a partir de 2012.

A maior flexibilidade do conjunto – mesmo durante o funcionamento – é outro ganho significativo das novas telas, e possibilitam o desenvolvimento de gadgets ainda mais inovadores. Formatos diferenciados e até mesmo a mudança de conformação passam a ser possíveis com displays não rígidos.

Além disso, o composto utilizado também favorece a visualização da tela, por permitir a melhor transmissão da luz gerada no painel TFT. Assim, todo o potencial do AMOLED – maior contraste, melhor reprodução de cores e a independência de iluminação traseira – passa a ser utilizado.

Pela posição do equipamento de sensibilidade, de nada adianta a tela da Samsung ser inquebrável, se ao menor impacto o funcionamento da touchscreen for comprometido.

Ou seja, ainda que não seja um lançamento, a tecnologia da tela flexível, leve e inquebrável estará em breve nas mãos dos consumidores.

Agora veja o video abaixo e veja como vai ser os monitores à prova de marteladas

sexta-feira, 9 de julho de 2010

Quanto cabe em um yottabyte?

Armazenar dados é uma das principais necessidades modernas. Cartões de memória, discos rígidos, SSDs e uma infinidade de dispositivos são criados e comercializados diariamente com esse único propósito. A quantidade de dados existente é tão grande que a maioria das pessoas não consegue nem mesmo conceber a grandeza – composta basicamente por “0” e “1” – dessa informação toda.

Atualmente, graças às limitações da tecnologia disponível, o limite teórico para a capacidade de armazenamento de dados por um computador é um yottabyte. Para não assustar ninguém com números realmente enormes, com milhares de zeros depois dos primeiros caracteres, o Baixaki vai mostrar, neste artigo, o que exatamente é um yottabyte (YB).

Para começar a matar a curiosidade: o nome é derivado da nona letra do alfabeto grego – “I”, chamada iota.

Provavelmente, se você tivesse um yottabyte disponível, não precisaria mais se preocupar com espaço para guardar tudo o que quisesse. Inclusive toda a informação disponível na rede mundial de computadores. Acredita-se que hoje, em 2010, todos os dados que compõem a web somem um zettabyte (ZB), que é a grandeza imediatamente inferior.

Para entender melhor isso, pense que um zettabyte está para o yottabyte, assim como o megabyte está para o gigabyte. Ou seja, para ocupar um yottabyte, são necessários 1024 zettabytes.

Certamente, uma das melhores maneiras de apreender o tamanho de um yottabyte é pensando em quantos arquivos podem ser armazenados ao mesmo tempo em uma unidade, certo?

Seguindo uma escala crescente: em um HD de 1 terabyte (TB) é possível armazenar – em média –200 mil músicas em MP3. Para atingir o petabyte (PB), são necessários 1024 terabytes. A próxima base é o exabyte (EB), que comporta 1024 petabytes.

Logo depois está o zettabyte que você já conheceu, com 1024 petabytes. Em arquivos de MP3, essa conta toda equivale a aproximadamente 214.749.438.541.824 músicas. Isso mesmo: em um yottabyte cabem – literalmente – trilhões de músicas!

Sim, existe um número exato para um yottabyte. Não se assuste, pois ele é alto, e – na verdade – é até difícil de ler o valor corretamente. Mas aí vai: 1.208.925.819.614.629.174.706.176 Bytes. Arredondando, pode-se dizer que um yottabyte é igual a 1.000.000.000.000.000.000.000.000 de conjuntos de zeros e uns.

A grande questão é : se todos os discos rígidos do mundo – hoje – juntos não conseguem armazenar essa quantidade de dados, qual é a maneira prevista pela NSA (“National Security Agency” – agência de segurança nacional) estadunidense para construir um datacenter capaz de guardar essa quantidade de informação? E quais os motivos que levam a agência a querer esse complexo informacional?

A resposta à primeira pergunta é praticamente impossível de responder. Como os militares americanos – e por consequência as agências governamentais – investem pesado em tecnologia, é possível que tenham desenvolvido alguma maneira realista de condensar a armazenagem de dados para que um único prédio consiga resguardar um yottabyte.

A resposta à primeira pergunta é praticamente impossível de responder. Como os militares americanos – e por consequência as agências governamentais – investem pesado em tecnologia, é possível que tenham desenvolvido alguma maneira realista de condensar a armazenagem de dados para que um único prédio consiga resguardar um yottabyte.

Porém, usando apenas tecnologia já disponível comercialmente, é economicamente inviável montar um datacenter dessa grandeza. Os maiores HDs atualmente no mercado armazenam até 2 TB de dados e um gabinete de servidor costuma receber em média quatro unidades de armazenagem.

Porém, usando apenas tecnologia já disponível comercialmente, é economicamente inviável montar um datacenter dessa grandeza. Os maiores HDs atualmente no mercado armazenam até 2 TB de dados e um gabinete de servidor costuma receber em média quatro unidades de armazenagem.

Com essa configuração, seriam necessários 128 gabinetes para resguardar um petabyte, alocados em 8 racks com espaço para 16 servidores. O próximo passo rumo ao datacenter de um yottabyte seria reunir mil racks em um único prédio, totalizando um exabyte. Este edifício ocuparia uma área equivalente a um quarteirão urbano, e teria dois andares.

Com essa configuração, seriam necessários 128 gabinetes para resguardar um petabyte, alocados em 8 racks com espaço para 16 servidores. O próximo passo rumo ao datacenter de um yottabyte seria reunir mil racks em um único prédio, totalizando um exabyte. Este edifício ocuparia uma área equivalente a um quarteirão urbano, e teria dois andares.

Para atingir o zettabyte que – acredita-se – acumule todos os dados da internet atual, são necessários pelo menos 500 desses prédios, usando aproximadamente 6 km² de área – pouco menor que 1/4 do espaço ocupado pela Vila Mariana, em São Paulo.

Para atingir o zettabyte que – acredita-se – acumule todos os dados da internet atual, são necessários pelo menos 500 desses prédios, usando aproximadamente 6 km² de área – pouco menor que 1/4 do espaço ocupado pela Vila Mariana, em São Paulo.

Depois disso, chega-se às portas do yottabyte. Mas ultrapassar esse limite não é tão fácil quanto parece. Para reunir todos os bits que compõem a medida – teoricamente – máxima de armazenagem da informática, seria necessário construir mais ou menos 500 mil centrais de dados.

Depois disso, chega-se às portas do yottabyte. Mas ultrapassar esse limite não é tão fácil quanto parece. Para reunir todos os bits que compõem a medida – teoricamente – máxima de armazenagem da informática, seria necessário construir mais ou menos 500 mil centrais de dados.

Isso mesmo, mil vezes mais prédios do que os necessários para se obter o zettabyte, ocupando quase dez mil km², ou duas vezes o terreno ocupado pelo Distrito Federal.

Isso mesmo, mil vezes mais prédios do que os necessários para se obter o zettabyte, ocupando quase dez mil km², ou duas vezes o terreno ocupado pelo Distrito Federal.

Agora que é – quase – possível entender a magnitude da empreitada da NSA, prepare-se para descobrir a razão do projeto.

O superdatacenter de um yottabyte que os estadunidenses pretendem construir se destina – principalmente – a armazenar vídeos de segurança. Câmeras de vigilância são cada vez mais comuns, e a quantidade de informação gerada também é enorme.

A julgar por seriados e filmes policiais, a qualidade dos vídeos ainda não é das melhores, mas isso tende a mudar com o avanço da tecnologia. Imagens melhores significam mais informação, e, portanto, faz sentido querer espaço de sobra para guardar a filmagem de milhões de câmeras sem precisar apagar outros arquivos.

Afinal, não é de hoje que os Estados Unidos resguardam a segurança do seu território com determinação e tecnologia.

Via: Baixaki

Atualmente, graças às limitações da tecnologia disponível, o limite teórico para a capacidade de armazenamento de dados por um computador é um yottabyte. Para não assustar ninguém com números realmente enormes, com milhares de zeros depois dos primeiros caracteres, o Baixaki vai mostrar, neste artigo, o que exatamente é um yottabyte (YB).

Para começar a matar a curiosidade: o nome é derivado da nona letra do alfabeto grego – “I”, chamada iota.

A internet em um só lugar

Para entender melhor isso, pense que um zettabyte está para o yottabyte, assim como o megabyte está para o gigabyte. Ou seja, para ocupar um yottabyte, são necessários 1024 zettabytes.

Uma conta “simples”

Seguindo uma escala crescente: em um HD de 1 terabyte (TB) é possível armazenar – em média –200 mil músicas em MP3. Para atingir o petabyte (PB), são necessários 1024 terabytes. A próxima base é o exabyte (EB), que comporta 1024 petabytes.

Logo depois está o zettabyte que você já conheceu, com 1024 petabytes. Em arquivos de MP3, essa conta toda equivale a aproximadamente 214.749.438.541.824 músicas. Isso mesmo: em um yottabyte cabem – literalmente – trilhões de músicas!

Em números

Como obter um yottabyte

Motivo de segurança

O superdatacenter de um yottabyte que os estadunidenses pretendem construir se destina – principalmente – a armazenar vídeos de segurança. Câmeras de vigilância são cada vez mais comuns, e a quantidade de informação gerada também é enorme.

A julgar por seriados e filmes policiais, a qualidade dos vídeos ainda não é das melhores, mas isso tende a mudar com o avanço da tecnologia. Imagens melhores significam mais informação, e, portanto, faz sentido querer espaço de sobra para guardar a filmagem de milhões de câmeras sem precisar apagar outros arquivos.

Afinal, não é de hoje que os Estados Unidos resguardam a segurança do seu território com determinação e tecnologia.

Via: Baixaki

quarta-feira, 7 de julho de 2010

Flow Switching: a internet até 1000 vezes mais rápida

Pesquisadores do MIT (sigla em inglês para Instituto Tecnológico do Massachusetts) desenvolveram um projeto que simplesmente pode aumentar a velocidade da internet entre 100 e 1000 vezes.

O segredo de tanta velocidade é um modelo que dispensa a conversão dos sinais óticos em elétricos. Além de muito mais velocidade, a tecnologia proposta consome muito menos energia.

Como os pesquisadores pretendem revolucionar a internet? Você descobre agora neste artigo.

As fibras óticas carregam dados a velocidades impressionantes, porém eles precisam ser convertidos em sinais elétricos pelos roteadores. Os roteadores encontram problemas quando precisam converter sinais óticos vindos de direções diferentes.

Sendo assim, os sinais óticos são convertidos em elétricos e armazenados dentro do roteador para serem enviados quando o “trânsito” de diferentes direções estiver ordenado. Obviamente, todo esse processo consome tempo e energia.

Fluxo sob controle

O projeto dos pesquisadores do MIT — liderados pelo engenheiro elétrico e professor Vincent Chan — demonstrou uma nova maneira de reorganizar os dados de redes óticas que, na maioria das vezes, dispensaria o processo de conversão.

A solução proposta chama-se Flow Switching. Entre duas localidades que trocam grandes volumes de dados entre si, o Switching é capaz de estabelecer um caminho direto e dedicado no qual roteadores aceitam sinais somente de uma direção e os enviam também em uma única direção. Assim, não é necessário converter o ótico em elétrico para redistribuição.

De fato, um modelo parecido já é aplicado por empresas muito grandes capazes de manter vários servidores espalhados por diferentes localidades. Um exemplo é a gigante Google. A diferença é que com o Flow Switching a banda larga seria usada de maneira flexível conforme a demanda de tráfego dos dados.

Por exemplo, se o trajeto entre A e B está bastante requisitado, o protocolo criado por Chan e sua equipe realocaria a banda em questão de segundos. Caso contrário, as ondas com os sinais simplesmente cessariam.

Vinga?

Esta não é a primeira tentativa de otimizar a transferência de dados via rede ótica, no entanto, o Flow Switching se mostra muito mais prático. Essa é a opinião de Ori Gerstel, engenheiro da Cisco Systems, fabricante de roteadores americana. O obstáculo, segundo ele, é a demanda para trocar todos os roteadores existentes pelos novos, pois ainda não está claro se há realmente a necessidade de tal mudança.

Segundo Gerstel, o Flow Switching é ideal para usuários que querem muita banda com poucos atrasos, mas a maioria dos consumidores de hoje não se encontra nesse nicho. A resposta de Chan é imediata: a explosão dos vídeos pela internet com o crescimento do HD.

Junta-se a isso a popularidade do acesso, que tende a aumentar, e tem-se facilmente a equação: as conexões atuais podem não dar conta e em pouco tempo, cinco anos talvez.

Na prática, o raciocínio é simples: durante o mesmo tempo que você demora para baixar 100 MB, você baixaria 10 GB. O Flow Switching está em testes nos Estados Unidos e deverá ser disponibilizada para trials limitados.

Clicando aqui você acessa a página com todo o projeto do Flow Switching. O documento é extenso e em inglês, o que exige conhecimento avançado do idioma.

Fonte: Baixaki

O segredo de tanta velocidade é um modelo que dispensa a conversão dos sinais óticos em elétricos. Além de muito mais velocidade, a tecnologia proposta consome muito menos energia.

Como os pesquisadores pretendem revolucionar a internet? Você descobre agora neste artigo.

As fibras óticas carregam dados a velocidades impressionantes, porém eles precisam ser convertidos em sinais elétricos pelos roteadores. Os roteadores encontram problemas quando precisam converter sinais óticos vindos de direções diferentes.

Sendo assim, os sinais óticos são convertidos em elétricos e armazenados dentro do roteador para serem enviados quando o “trânsito” de diferentes direções estiver ordenado. Obviamente, todo esse processo consome tempo e energia.

Fluxo sob controle

O projeto dos pesquisadores do MIT — liderados pelo engenheiro elétrico e professor Vincent Chan — demonstrou uma nova maneira de reorganizar os dados de redes óticas que, na maioria das vezes, dispensaria o processo de conversão.

A solução proposta chama-se Flow Switching. Entre duas localidades que trocam grandes volumes de dados entre si, o Switching é capaz de estabelecer um caminho direto e dedicado no qual roteadores aceitam sinais somente de uma direção e os enviam também em uma única direção. Assim, não é necessário converter o ótico em elétrico para redistribuição.

De fato, um modelo parecido já é aplicado por empresas muito grandes capazes de manter vários servidores espalhados por diferentes localidades. Um exemplo é a gigante Google. A diferença é que com o Flow Switching a banda larga seria usada de maneira flexível conforme a demanda de tráfego dos dados.

Por exemplo, se o trajeto entre A e B está bastante requisitado, o protocolo criado por Chan e sua equipe realocaria a banda em questão de segundos. Caso contrário, as ondas com os sinais simplesmente cessariam.

Vinga?

Esta não é a primeira tentativa de otimizar a transferência de dados via rede ótica, no entanto, o Flow Switching se mostra muito mais prático. Essa é a opinião de Ori Gerstel, engenheiro da Cisco Systems, fabricante de roteadores americana. O obstáculo, segundo ele, é a demanda para trocar todos os roteadores existentes pelos novos, pois ainda não está claro se há realmente a necessidade de tal mudança.

Segundo Gerstel, o Flow Switching é ideal para usuários que querem muita banda com poucos atrasos, mas a maioria dos consumidores de hoje não se encontra nesse nicho. A resposta de Chan é imediata: a explosão dos vídeos pela internet com o crescimento do HD.

Junta-se a isso a popularidade do acesso, que tende a aumentar, e tem-se facilmente a equação: as conexões atuais podem não dar conta e em pouco tempo, cinco anos talvez.

Na prática, o raciocínio é simples: durante o mesmo tempo que você demora para baixar 100 MB, você baixaria 10 GB. O Flow Switching está em testes nos Estados Unidos e deverá ser disponibilizada para trials limitados.

Para sua curiosidade (em inglês)

Fonte: Baixaki

segunda-feira, 5 de julho de 2010

HDbaseT: o fim do HDMI!

Todo dia é assim: tecnologias desatualizadas são aposentadas para dar lugares a outras mais eficientes. Não que o HDMI seja antigo ou que sua qualidade deixe a desejar, mas é raro encontrar um padrão no mundo da informática ou dos eletrônicos que consiga durar muito tempo.

Com o HDMI não deve ser diferente, porque além de já sofrer uma baixa considerável com as atuais placas de vídeo trazendo conexões do tipo DisplayPort, ele deve ganhar um concorrente ainda mais perigoso: o HDbaseT.

Conheça o novo padrão

Você já conectou um cabo de rede no seu PC? Então imagine se fosse possível usar o mesmo tipo de cabo para transmitir imagem e vídeo para a sua TV. O propósito do HDbaseT e o funcionamento é exatamente esse. O usuário não precisa investir em um novo cabo, aliás, pode economizar e comprar um cabo de até cem metros para assistir aos vídeos favoritos.

Com o apoio e a ajuda tecnológica da Samsung, LG e Sony, a Valens Semiconductor (empresa responsável pelo padrão) está dando os primeiros passos na criação e implementação desta nova tecnologia. Possivelmente os produtos atuais com conexão para rede não vão ser compatíveis com o HDbaseT, isso porque quaisquer aparelhos já existentes usam a porta LAN para conectar-se a uma rede.

E a qualidade?

O novo padrão promete ser milagroso, tanto no quesito inovação como na qualidade. Consultando o documento PDF do site oficial obtivemos diversos parâmetros que mostram a superioridade do HDbaseT quando comparado ao HDMI.

Na realidade em alguns aspectos ele até empata com o HDMI, mas levando em consideração todos os benefícios do novo padrão, não há como duvidar da possível dominação no mercado dos eletrônicos. Veja abaixo uma tabela comparativa entre os quatro padrões de maior qualidade:

O site oficial do HDbaseT ainda dá acesso a outras informações que podem interessar aos entusiastas de plantão. Além da capacidade de transmissão de vídeos em Full HD e vídeos não comprimidos, o HDbaseT consegue transmitir no padrão 3D e ainda no formato 2Kx4K (com resoluções que atingem mais de 4.000 pixels).

Essa moda pega com certeza!

Por que adotar um novo padrão? Simples: porque ele é melhor do que tudo o que já existe. No caso do HDbaseT ele é melhor em cinco tarefas diferentes. O usuário pode transmitir: vídeos de alta definição, faixas de áudio com qualidade incomparável, internet de 1000 Mbps (ou seja, 1 Gigabit), energia (para ligar aparelhos a longa distância) e controles diversos para interação.

Obviamente o grande trunfo do HDbaseT não está somente nesses benefícios, mas também no comprimento do cabo que chega a 100 metros e no custo barateado. Ainda não há data definida para a chegada oficial do novo padrão, mas o mais recente documento com informações dá conta que a padronização está finalizada e as fabricantes devem criar novos eletrônicos com o padrão em breve.

Obviamente o grande trunfo do HDbaseT não está somente nesses benefícios, mas também no comprimento do cabo que chega a 100 metros e no custo barateado. Ainda não há data definida para a chegada oficial do novo padrão, mas o mais recente documento com informações dá conta que a padronização está finalizada e as fabricantes devem criar novos eletrônicos com o padrão em breve.

Parece que as fabricantes vão acertar desta vez, mas os consumidores terão que gastar novamente com um padrão de vídeo (tanto em televisores como em DVDs ou players de Blu-ray). Você acha que vale a pena investir nos cabos de rede para substituir o HDMI?

Via:Baixaki

Com o HDMI não deve ser diferente, porque além de já sofrer uma baixa considerável com as atuais placas de vídeo trazendo conexões do tipo DisplayPort, ele deve ganhar um concorrente ainda mais perigoso: o HDbaseT.

Conheça o novo padrão

Você já conectou um cabo de rede no seu PC? Então imagine se fosse possível usar o mesmo tipo de cabo para transmitir imagem e vídeo para a sua TV. O propósito do HDbaseT e o funcionamento é exatamente esse. O usuário não precisa investir em um novo cabo, aliás, pode economizar e comprar um cabo de até cem metros para assistir aos vídeos favoritos.

Com o apoio e a ajuda tecnológica da Samsung, LG e Sony, a Valens Semiconductor (empresa responsável pelo padrão) está dando os primeiros passos na criação e implementação desta nova tecnologia. Possivelmente os produtos atuais com conexão para rede não vão ser compatíveis com o HDbaseT, isso porque quaisquer aparelhos já existentes usam a porta LAN para conectar-se a uma rede.

E a qualidade?

O novo padrão promete ser milagroso, tanto no quesito inovação como na qualidade. Consultando o documento PDF do site oficial obtivemos diversos parâmetros que mostram a superioridade do HDbaseT quando comparado ao HDMI.

Na realidade em alguns aspectos ele até empata com o HDMI, mas levando em consideração todos os benefícios do novo padrão, não há como duvidar da possível dominação no mercado dos eletrônicos. Veja abaixo uma tabela comparativa entre os quatro padrões de maior qualidade:

| Característica | HDMI (versão 1.4) | DiiVA | DisplayPort (versão 1.2) | HDbaseT (versão 1.0) |

| Vídeo e áudio não-comprimido | 10,2 Gbps | 13,5 Gbps | 21,6 Gbps | 10,2 Gbps (padrão atual) Até 20 Gbps (num padrão futuro) |

| Comprimento máximo do cabo | Poucos metros (em média 3 metros) | 26 metros | 15 metros (limitações aplicáveis) | Até 100 metros (utilização comum) Até 800 metros (com a ajuda de repetidores de sinal) |

| Tipo do cabo | Cabo HDMI | Cabo proprietário da DiiVA | Cabo DisplayPort | Qualquer cabo de rede do padrão Cat5e/6 |

| Tipo do conector | Conector HDMI | Conector proprietário da DiiVA | Conector DisplayPort | Qualquer conector do padrão RJ-45 |

| Transmite energia? | Não | 5W | Não | Até 100W |

| Rede (Internet) | 100 Mbps | Gigabit | 720 Mbps | 1000 Mbps (Gigabit) |

| Topologia de rede | Não | Sim | Sim | Sim |

| Instalação amigável | Não | Não | Não | Sim |

| USB | Não | Sim | Sim | Sim |

| Recursos extras de rede | Nenhum | Topologias com limitações | Topologias com limitações | Topologias sem limitações e conectividade acessível a qualquer computador e rede. |

Essa moda pega com certeza!

Por que adotar um novo padrão? Simples: porque ele é melhor do que tudo o que já existe. No caso do HDbaseT ele é melhor em cinco tarefas diferentes. O usuário pode transmitir: vídeos de alta definição, faixas de áudio com qualidade incomparável, internet de 1000 Mbps (ou seja, 1 Gigabit), energia (para ligar aparelhos a longa distância) e controles diversos para interação.

Parece que as fabricantes vão acertar desta vez, mas os consumidores terão que gastar novamente com um padrão de vídeo (tanto em televisores como em DVDs ou players de Blu-ray). Você acha que vale a pena investir nos cabos de rede para substituir o HDMI?

Via:Baixaki

Todo dia é assim: tecnologias desatualizadas são aposentadas para dar lugares a outras mais eficientes. Não que o HDMI seja uma tecnologia antiga ou de baixa qualidade, mas é raro encontrar um padrão no mundo da informática ou dos eletrônicos que consiga durar muito tempo.

Com o HDMI não deve ser diferente, porque além de já sofrer uma baixa considerável com as atuais placas de vídeo trazendo conexões do tipo DisplayPort, ele deve ganhar um concorrente ainda mais perigoso: o HDbaseT.

Conheça o novo padrão

Você já conectou um cabo de rede no seu PC? Então imagine se fosse possível usar o mesmo tipo de cabo para transmitir imagem e vídeo para a sua TV. O propósito do HDbaseT e o funcionamento é exatamente este. O usuário não precisa investir em um novo cabo, aliás, pode economizar e comprar um cabo de até cem metros para assistir aos vídeos favoritos.

Com o apoio e ajuda técnológica da Samsung, LG e Sony, a Valens Semiconductor (empresa responsável pelo padrão) está dando os primeiros passos na criação e implementação desta nova tecnologia. Possivelmente os produtos atuais com conexão para rede não vão ser compatíveis com o HDbaseT, isso porque quaisquer aparelhos já existentes usam a porta LAN para conectar-se a uma rede.

E a qualidade?

O novo padrão promete ser milagroso, tanto no quesito inovação como na qualidade. Consultando o documento PDF do site oficial obtivemos diversos parâmetros que mostram a superioridade do HDbaseT quando comparado ao HDMI.

Na realidade em alguns aspectos ele até empata com o HDMI, mas levando em consideração todos os benefícios do novo padrão, não há como duvidar da possível dominação no mercado dos eletrônicos. Veja abaixo uma tabela comparativa entre os quatro padrões de maior qualidade:

[Tabela]

O site oficial do HDbaseT ainda dá acesso a outras informações que podem interessar aos entusiastas de plantão. Além da capacidade de transmissão de vídeos em Full HD e vídeos não-comprimidos, o HDbaseT consegue transmitir no padrão 3D e ainda no formato 2Kx4K (com resoluções que atingem mais de 4.000 pixels).

Essa moda pega com certeza!

Por que adotar um novo padrão? Simples: porque ele é melhor do que tudo que já existe. No caso do HDbaseT ele é melhor em cinco tarefas diferentes. O usuário pode transmitir: vídeos de alta definição, faixas de áudio com qualidade incomparável, internet de 1000 Mbps (Gigabit), energia (para ligar aparelhos a longa distância) e controles diversos para interação.

Obviamente o grande trunfo do HDbaseT não está somente nestes benefícios, mas também no comprimento do cabo que chega a 100 metros e no custo barateado. Ainda não há data definida para a chegada oficial do novo padrão, mas o mais recente documento com informações dá conta que a padronização está finalizada e as fabricantes devem criar novos eletrônicos com o padrçao em breve.

Parece que as fabricantes vão acertar desta vez, mas os consumidores terão que gastar novamente com um padrão de vídeo. Você acha que vale a pena investir nos cabos de rede para substituir o HDMI? Dê sua opinião!

Com o HDMI não deve ser diferente, porque além de já sofrer uma baixa considerável com as atuais placas de vídeo trazendo conexões do tipo DisplayPort, ele deve ganhar um concorrente ainda mais perigoso: o HDbaseT.

Conheça o novo padrão

Você já conectou um cabo de rede no seu PC? Então imagine se fosse possível usar o mesmo tipo de cabo para transmitir imagem e vídeo para a sua TV. O propósito do HDbaseT e o funcionamento é exatamente este. O usuário não precisa investir em um novo cabo, aliás, pode economizar e comprar um cabo de até cem metros para assistir aos vídeos favoritos.

Com o apoio e ajuda técnológica da Samsung, LG e Sony, a Valens Semiconductor (empresa responsável pelo padrão) está dando os primeiros passos na criação e implementação desta nova tecnologia. Possivelmente os produtos atuais com conexão para rede não vão ser compatíveis com o HDbaseT, isso porque quaisquer aparelhos já existentes usam a porta LAN para conectar-se a uma rede.

E a qualidade?

O novo padrão promete ser milagroso, tanto no quesito inovação como na qualidade. Consultando o documento PDF do site oficial obtivemos diversos parâmetros que mostram a superioridade do HDbaseT quando comparado ao HDMI.

Na realidade em alguns aspectos ele até empata com o HDMI, mas levando em consideração todos os benefícios do novo padrão, não há como duvidar da possível dominação no mercado dos eletrônicos. Veja abaixo uma tabela comparativa entre os quatro padrões de maior qualidade:

[Tabela]

O site oficial do HDbaseT ainda dá acesso a outras informações que podem interessar aos entusiastas de plantão. Além da capacidade de transmissão de vídeos em Full HD e vídeos não-comprimidos, o HDbaseT consegue transmitir no padrão 3D e ainda no formato 2Kx4K (com resoluções que atingem mais de 4.000 pixels).

Essa moda pega com certeza!

Por que adotar um novo padrão? Simples: porque ele é melhor do que tudo que já existe. No caso do HDbaseT ele é melhor em cinco tarefas diferentes. O usuário pode transmitir: vídeos de alta definição, faixas de áudio com qualidade incomparável, internet de 1000 Mbps (Gigabit), energia (para ligar aparelhos a longa distância) e controles diversos para interação.

Obviamente o grande trunfo do HDbaseT não está somente nestes benefícios, mas também no comprimento do cabo que chega a 100 metros e no custo barateado. Ainda não há data definida para a chegada oficial do novo padrão, mas o mais recente documento com informações dá conta que a padronização está finalizada e as fabricantes devem criar novos eletrônicos com o padrçao em breve.

Parece que as fabricantes vão acertar desta vez, mas os consumidores terão que gastar novamente com um padrão de vídeo. Você acha que vale a pena investir nos cabos de rede para substituir o HDMI? Dê sua opinião!

segunda-feira, 14 de junho de 2010

Microsoft apresenta novo xbox 360 na E3

Procedimento feito a algum tempo pela sony,de fazer uma versão slim de seus consoles,a Microsoft resolveu entra nesse ramo de "slims" aprensentando hoje, em sua conferência na E3,a versão slim do xbox 360.

O novo modelo do xbox 360 traz algumas novidades em sua parte estética, com curvas mais acentuadas, e cores mais brilhosas parecendo muito com o console PS3 de cor preta .O xbox 360 slim também traz outras novidades,como o wi-fi, e também já vem preparado para o Kinect(Câmera de movimentos da Microsoft).

Na questão de preço, a Microsoft promete que não vai fazer nenhum reajuste, comparado sua versão anterior,sendo que o preço é de U$:299,00 o mesmo praticado antes pela

Microsoft.O Xbox 360 slim já vai ser comercializado á partir de hoje nos EUA

domingo, 13 de junho de 2010

O que são multi e hyper-threading?

Os processadores foram os componentes de computador que tiveram uma evolução galopante desde seu primeiro modelo até os que encontramos hoje no mercado. Para aumentar a velocidade dos processadores e a dos computadores, diversas tecnologias novas foram desenvolvidas.

Hoje você não precisa procurar muito para encontrar computadores que tenham processadores com mais de um núcleo, ou que possam simular diversos. Porém, as especificações destas máquinas muitas vezes utilizam nomes específicos como Multithread ou Hyper-threading e geram dúvidas sobre seu funcionamento.

O que é Thread?

Em palavras simples, uma thread é um conjunto de tarefas existentes em um ou mais programas, executadas ao mesmo tempo pelo processador. Por exemplo, você não precisa parar de ouvir música enquanto utiliza um editor de texto, muito menos fechar uma janela de seu navegador para imprimir uma imagem. Agora pense em diversas tarefas dentro de um único processo (como a emissão de sons e imagens ao mesmo tempo em um jogo) e você tem threads.

Uma Thread acontece quando um programa precisa resolver duas ou mais tarefas concorrentes (e em andamento). Threads não são processos, estando contidas dentro de processos. Pode haver múltiplas threads dentro de um mesmo processo (ao menos uma sempre existe) e também é possível dividir recursos do computador (como memória e arquivos abertos, por exemplo), enquanto processos não podem fazê-lo.

Uma Thread acontece quando um programa precisa resolver duas ou mais tarefas concorrentes (e em andamento). Threads não são processos, estando contidas dentro de processos. Pode haver múltiplas threads dentro de um mesmo processo (ao menos uma sempre existe) e também é possível dividir recursos do computador (como memória e arquivos abertos, por exemplo), enquanto processos não podem fazê-lo.

Nos computadores cujo processador possui um núcleo, as threads são processadas de maneira, aparentemente, simultânea, pois a mudança entre uma e outra é feita de maneira muito rápida. Nos computadores cujo processador tem mais do que um núcleo, as threads são efetivamente realizadas de forma simultânea.

Resumindo...

Normalmente, um processo (de qualquer programa) é dividido em várias linhas, as quais possuem ordens específicas. Cada linha pode ser lida e processada separadamente pelo processador. Estas linhas são o que chamamos de Threads. Evidentemente, para que as Threads possam ser executadas ao mesmo tempo, o computador precisa de duas coisas: um sistema capaz de realizar esta divisão de threads e um processador capaz de executar várias threads.

Multithread

Multithreading é a capacidade que o sistema operacional possui de executar várias threads simultaneamente sem que uma interfira na outra. Estas threads compartilham os recursos do processo, mas são capazes de ser executadas de forma independente. Para possuir processamento multithread “real”, os processadores precisam ser capazes de atender duas ou mais threads ao mesmo tempo e não simular este efeito, atendendo-as uma por vez em um curto período de tempo.

A maior vantagem trazida com a execução multithread é permitir que os computadores com múltiplos núcleos de processamento possam aproveitar todo o seu potencial e operar de forma mais rápida. Apenas para ilustrar, nos computadores sem este tipo de suporte, quando o processo principal toma muito tempo, a aplicação inteira parece travar.

SuperThreading

Esta tecnologia foi desenvolvida a partir da observação de que algumas vezes o processador era deixado ocioso enquanto executava as instruções de uma thread (nem todo processo requisita toda a capacidade do processador). O objetivo principal era aproveitar este período de ociosidade para a execução de instruções de outra thread.

Na execução SuperThreading o processador pode executar instruções de threads diferentes para cada ciclo de processamento. Entretanto, quando um destes ciclos não está mais sendo utilizado por determinada thread, é aproveitado para executar outra que esteja pronta.

Hyper-threading

Hyper-threading ou Simultaneous multithreading (SMT), basicamente, seria uma espécie de evolução da tecnologia SuperThreading, porém sem a limitação de que todas as instruções executadas em um mesmo ciclo de processamento sejam da mesma thread.

A tencologia de Hyper-thread permite que as threads sejam executadas em paralelo (paralelismo) dentro de cada núcleo de processador existente no computador. Este tipo de processamento aproveita de forma mais eficiente o uso dos recursos dos processadores e melhora ainda mais a performance multithread dos programas. Na imagem abaixo você pode conferir a presença da tecnologia Hyper-threading (HT) nos processadores Pentium 4.

A tencologia de Hyper-thread permite que as threads sejam executadas em paralelo (paralelismo) dentro de cada núcleo de processador existente no computador. Este tipo de processamento aproveita de forma mais eficiente o uso dos recursos dos processadores e melhora ainda mais a performance multithread dos programas. Na imagem abaixo você pode conferir a presença da tecnologia Hyper-threading (HT) nos processadores Pentium 4.

Como um exemplo atual, poderíamos utilizar os processadores Core i7 da Intel, que apesar de possuírem quatro núcleos físicos, simulam o funcionamento de oito.

Hoje você não precisa procurar muito para encontrar computadores que tenham processadores com mais de um núcleo, ou que possam simular diversos. Porém, as especificações destas máquinas muitas vezes utilizam nomes específicos como Multithread ou Hyper-threading e geram dúvidas sobre seu funcionamento.

O que é Thread?

Em palavras simples, uma thread é um conjunto de tarefas existentes em um ou mais programas, executadas ao mesmo tempo pelo processador. Por exemplo, você não precisa parar de ouvir música enquanto utiliza um editor de texto, muito menos fechar uma janela de seu navegador para imprimir uma imagem. Agora pense em diversas tarefas dentro de um único processo (como a emissão de sons e imagens ao mesmo tempo em um jogo) e você tem threads.

Nos computadores cujo processador possui um núcleo, as threads são processadas de maneira, aparentemente, simultânea, pois a mudança entre uma e outra é feita de maneira muito rápida. Nos computadores cujo processador tem mais do que um núcleo, as threads são efetivamente realizadas de forma simultânea.

Resumindo...

Normalmente, um processo (de qualquer programa) é dividido em várias linhas, as quais possuem ordens específicas. Cada linha pode ser lida e processada separadamente pelo processador. Estas linhas são o que chamamos de Threads. Evidentemente, para que as Threads possam ser executadas ao mesmo tempo, o computador precisa de duas coisas: um sistema capaz de realizar esta divisão de threads e um processador capaz de executar várias threads.

Multithread

Multithreading é a capacidade que o sistema operacional possui de executar várias threads simultaneamente sem que uma interfira na outra. Estas threads compartilham os recursos do processo, mas são capazes de ser executadas de forma independente. Para possuir processamento multithread “real”, os processadores precisam ser capazes de atender duas ou mais threads ao mesmo tempo e não simular este efeito, atendendo-as uma por vez em um curto período de tempo.

A maior vantagem trazida com a execução multithread é permitir que os computadores com múltiplos núcleos de processamento possam aproveitar todo o seu potencial e operar de forma mais rápida. Apenas para ilustrar, nos computadores sem este tipo de suporte, quando o processo principal toma muito tempo, a aplicação inteira parece travar.

SuperThreading

Esta tecnologia foi desenvolvida a partir da observação de que algumas vezes o processador era deixado ocioso enquanto executava as instruções de uma thread (nem todo processo requisita toda a capacidade do processador). O objetivo principal era aproveitar este período de ociosidade para a execução de instruções de outra thread.

Na execução SuperThreading o processador pode executar instruções de threads diferentes para cada ciclo de processamento. Entretanto, quando um destes ciclos não está mais sendo utilizado por determinada thread, é aproveitado para executar outra que esteja pronta.

Hyper-threading

Hyper-threading ou Simultaneous multithreading (SMT), basicamente, seria uma espécie de evolução da tecnologia SuperThreading, porém sem a limitação de que todas as instruções executadas em um mesmo ciclo de processamento sejam da mesma thread.

Veja que o Windows reconhece dois núcleos num processador que tem apenas um núcleo físico

Para deixar um pouco mais claro, pode-se dizer que um único processador com tecnologia hyper-threading habilitada é tratado pelo sistema operacional como dois processadores ao invés de apenas um. Assim sendo, um único processador físico poderia ser tratado pelo Sistema como dois processadores virtuais dividindo tarefas entre eles.Como um exemplo atual, poderíamos utilizar os processadores Core i7 da Intel, que apesar de possuírem quatro núcleos físicos, simulam o funcionamento de oito.

sexta-feira, 11 de junho de 2010

Grafeno:material é capaz de atingir frequências que podem passar dos 500 GHz nos processadores.

O silício, material utilizado em grande quantidade para a fabricação de processadores e outros componentes eletrônicos, parece estar com seus dias contados. Embora a cada ano surjam dispositivos mais eficientes, as limitações do material se tornam cada vez mais evidentes aos olhos dos desenvolvedores.

Nos últimos anos, a tendência para obter equipamentos melhores foi apostar na miniaturização dos componentes. Porém, conforme essa tecnologia mostra sinais de desgaste e se torna mais difícil alcançar desempenhos mais elevados, aumentam os esforços na busca por materiais baratos que sejam capazes de substituir o silício.

A aposta de material para os componentes do futuro é o grafeno, uma forma pura de carbono descoberta em 2004. Enquanto o silício suporta no máximo frequências entre 4 a 5 GHz, esse valor pode passar dos 500 Ghz caso o material utilizado seja o grafeno, devido às particularidades do material.

A aposta de material para os componentes do futuro é o grafeno, uma forma pura de carbono descoberta em 2004. Enquanto o silício suporta no máximo frequências entre 4 a 5 GHz, esse valor pode passar dos 500 Ghz caso o material utilizado seja o grafeno, devido às particularidades do material.

O Massachusetts Institute of Technology (MIT) desenvolveu um chip que tem o grafeno como base, capaz de multiplicar frequências. Após cruzar o chip, foi possível dobrar a frequência de um sinal eletromagnético, o que abre a possibilidade de criar componentes eletrônicos muito mais eficientes.

O grafeno é constituído por uma camada extremamente fina de grafite, o mesmo material encontrado em qualquer lápis comum. O que torna o material especial é a estrutura hexagonal com que seus átomos individuais estão distribuídos, que gera uma folha plana que, se enroladas, geram nanotubos de carbono.

Em um transistor, uma pequena corrente elétrica é utilizada para controlar uma porta por onde passa uma corrente muito maior: o componente funciona como uma chave que liga ou desliga a corrente conforme a necessidade do dispositivo.

Como o grafeno é um material extremamente fino e que permite que cargas elétricas fluam com facilidade, se mostra como uma alternativa ao silício na construção de transistores ainda mais eficientes.

Além de servir para a construção de transistores e multiplicadores de frequência, já se cogita utilizar o grafeno como substituto para o índio, material raro utilizado para a fabricação de televisores OLED.

O maior desafio enfrentado pelos desenvolvedores que apostam na nova tecnologia é conseguir tornar viável o processo de fabricação em larga escala. Como as folhas de grafeno possuem somente um átomo de espessura, a maioria dos componentes testados até o momento só foram possíveis por terem sido desenvolvidos em ambientes de laboratório.

Porém, tudo aponta que nos próximos anos haverá uma substituição gradual do silício pelo grafeno, como apontam as pesquisas feitas pelo Laboratório Nacional de Física, do Reino Unido.

Utilizando a mesma técnica utilizada para o crescimento de cristais, os pesquisadores foram capazes de desenvolver amostras de grafeno com 50 milímetros quadrados – pouco menor do que os processadores encontrados no mercado, e suficiente para a fabricação de componentes eletrônicos como transistores.

Nos últimos anos, a tendência para obter equipamentos melhores foi apostar na miniaturização dos componentes. Porém, conforme essa tecnologia mostra sinais de desgaste e se torna mais difícil alcançar desempenhos mais elevados, aumentam os esforços na busca por materiais baratos que sejam capazes de substituir o silício.

O Massachusetts Institute of Technology (MIT) desenvolveu um chip que tem o grafeno como base, capaz de multiplicar frequências. Após cruzar o chip, foi possível dobrar a frequência de um sinal eletromagnético, o que abre a possibilidade de criar componentes eletrônicos muito mais eficientes.

O que é o grafeno?

O grafeno é constituído por uma camada extremamente fina de grafite, o mesmo material encontrado em qualquer lápis comum. O que torna o material especial é a estrutura hexagonal com que seus átomos individuais estão distribuídos, que gera uma folha plana que, se enroladas, geram nanotubos de carbono.

Em um transistor, uma pequena corrente elétrica é utilizada para controlar uma porta por onde passa uma corrente muito maior: o componente funciona como uma chave que liga ou desliga a corrente conforme a necessidade do dispositivo.

Como o grafeno é um material extremamente fino e que permite que cargas elétricas fluam com facilidade, se mostra como uma alternativa ao silício na construção de transistores ainda mais eficientes.

Além de servir para a construção de transistores e multiplicadores de frequência, já se cogita utilizar o grafeno como substituto para o índio, material raro utilizado para a fabricação de televisores OLED.

Tecnologia sem prazo para virar padrão

Porém, tudo aponta que nos próximos anos haverá uma substituição gradual do silício pelo grafeno, como apontam as pesquisas feitas pelo Laboratório Nacional de Física, do Reino Unido.

Utilizando a mesma técnica utilizada para o crescimento de cristais, os pesquisadores foram capazes de desenvolver amostras de grafeno com 50 milímetros quadrados – pouco menor do que os processadores encontrados no mercado, e suficiente para a fabricação de componentes eletrônicos como transistores.

segunda-feira, 7 de junho de 2010

iPhone 4: ele mudará tudo. De novo!

A Apple, sem dúvida, tem tomado conta do mercado da alta tecnologia. Seus produtos, como o iPod, iPhone, iPad e o Mac OS, têm adquirido a cada dia novos seguidores. Seja pela qualidade ou efeitos visuais, o fato é que a Microsoft, Sony, Samsung e outras empresas de tecnologia têm enfrentado dificuldade em combater a marca da maçã.

Como Steve Jobs não abre mão de manter sua empresa como um símbolo de inovação e crescimento, mais novidades surgiram na Worldwide Developers Conference (WWDC) 2010 - evento focado em desenvolvedores da plataforma Apple.

Não podiamos ficar fora dessa e acompanhaos tudo que rolou na conferência que contou com mais de 5200 participantes de 57 países e aconteceu neste dia 7 de junho. Confira as informações e novidades que acabaram de sair do forno!

As vendas do iPad

Para os céticos que tinham o iPad como um aparelho fadado a decadência e que não passaria de um iPhone grande, Jobs começou sua apresentação passando alguns dados interessantes. O mais significativo é que a cada 3 segundos um iPad é vendido.

Aparentemente, as funcionalidades e novidades do aparelho tiveram uma ótima aceitação do mercado. Ou será que a Apple é apenas uma empresa perita em marketing de venda? Fato é que o CEO da organização está satisfeito e contente com o resultado do iPad. Segundo ele, os conceitos e visões gerais da empresa mudaram com o desenvolvimento desta tecnologia.

Aplicativos para tudo que é lado

Aplicativos para tudo que é lado

Uma das grandes reclamações no lançamento do iPad foi a quantidade de aplicativos disponíveis na loja virtual da empresa. A difusão do aparelho aumentou a preocupação da Apple com esse contexto, e a empresa buscou aprimorar sua App Store.

Hoje, ela conta com 8500 aplicativos para o modelo, os quais registraram cerca de 35 milhões de aquisições (aproximadamente 17 aplicativos por iPad). Essa foi mais uma ação para aproximar a marca de seus clientes.

iPhone 4

Eis que um dos lançamentos mais esperados pelos aficionados em tecnologia, finalmente, aconteceu: o iPhone 4 foi anunciado. O aparelho sofreu, de acordo com Steve Jobs, 100 reformulações, as quais devem agradar aqueles que priorizam qualidade de captação e reprodução de imagens, vida útil da bateria e dimensionamento reduzido.

Design renovado

Design renovado

O tamanho do iPhone já foi criticado por muita gente: alguns acham incômodo segurá-lo. Se essa era um motivo para não comprá-lo, pode esquecer. A nova versão do aparelho tem 9,3 milímetros de espessura (24% mais fino que o 3GS) e entra na briga entre os smartphones mais finos do mundo.

O design do iPhone também foi renovado. Além da redução de espessura, foram implementados vidros de alta resistência, tanto na frente como atrás do aparelho; aço inoxidável recobrindo os detalhes laterais; controles de volume; saída para fones; e entrada para cartões SIM. Confira no vídeo seguinte a aparência da novidade:

A engenharia aplicada na estruturação do eletrônico foi enfatizada por Jobs. Duas linhas, uma na lateral e outra na parte superior do aparelho, garantem uma melhor conectividade do iPhone com as tecnologias Wi-Fi, Bluetooth, GSM, UMTS e GPS.

Capacidade visual

A qualidade na exibição de imagens foi outro ponto que sofreu melhorias. Segundo o que foi apresentado na WWDC 2010, o iPhone 4 conta com uma nova tecnologia, chamada de Retina Display (em uma tradução livre, "Exibição de Retina"). Com essa novidade, o aparelho deve apresentar 326 pixels por polegada - 26 a mais do que a retina humana suporta -, o que proporciona maior nitidez das imagens e facilita a leitura de textos.

Além disso, a nova versão apresenta tela de OLED com 3,5 polegadas, resolução de 960 por 640 pixels e contraste de 800:1 - estas duas últimas configurações são quatro vezes maiores que as encontradas no iPhone 3GS.

Além disso, a nova versão apresenta tela de OLED com 3,5 polegadas, resolução de 960 por 640 pixels e contraste de 800:1 - estas duas últimas configurações são quatro vezes maiores que as encontradas no iPhone 3GS.

Câmeras

A capacidade de capturar imagens e vídeos do iPhone sempre foi um motivo de descrença na potencialidade do aparelho. Mais uma vez, a Apple buscou eliminar qualquer característica que tenha sofrido críticas. Nesta versão foi acrescentada uma câmera na parte frontal do smartphone, possibilitando a comunicação através de videoconferências.

Por sua vez, a câmera na parte traseira ganhou potência. Agora ela possui 5 mega pixels, zoom digital de 5 vezes e flash em LED. Dessa forma o iPhone suporta, também, gravar vídeos em alta definição (aqueles com 720p). Aliada à Retina Display, esta câmera deve surpreender na qualidade de fotos e filmagens.

Bateria prolongada

Bateria prolongada

O processamento de dados do iPhone 4 utiliza mais uma inovação da Apple: o chip A4. Pôde-se perceber, durante a apresentação na conferência, que a maior vantagem desta tecnologia é o tempo de vida útil da bateria.

Segundo os dados exibidos, o smartphone chega a operar em standby por 300 horas e em conversação por sete. Para aqueles que gostam de escutar suas bandas e cantores prediletos, uma informação animadora: são 40 horas de música sem parar!

Mais realidade aos jogos

Os gamers mais exigentes devem curtir a união entre as tecnologias no iPhone 4. O giroscópio conta com três eixos de movimentos na representação dos jogos. Entretanto, ao ser combinado com o potente acelerômetro do aparelho, o número de eixos passa para seis.

Isso significa maior realidade de movimentos nos jogos. Alguns API’s (interface de programação para aplicativos) para desenvolvedores já estão disponíveis, o que cria a expectativa de que em breve sejam lançados games adaptados a esta tecnologia.

Isso significa maior realidade de movimentos nos jogos. Alguns API’s (interface de programação para aplicativos) para desenvolvedores já estão disponíveis, o que cria a expectativa de que em breve sejam lançados games adaptados a esta tecnologia.

Enfim, multitarefas

O iPhone 4 tem todas as suas funcionalidades gerenciadas pelo sistema operacional IOS 4. Este lançamento da Apple proporciona que o usuário utilize vários aplicativos ao mesmo tempo, as denominadas multitarefas - característica amplamente criticada e que fez falta nos modelos anteriores.

A personalização do SO ficou mais flexível, possibilitando a alteração do plano de fundo em telas de bloqueio, por exemplo. A mobilidade e a renomeação de arquivos devem ser outros fatores muito práticos no IOS 4. Com ele, alterar o nome de uma pasta ou mover um documento para outro local é descomplicado e intuitivo.

Outra novidade desta versão do sistema operacional é o iBooks. Este aplicativo deve ser disponibilizado gratuitamente na loja virtual da Apple e vai mexer com o mercado de e-books. Segundo a desenvolvedora, o iBooks consegue sincronizar livros digitais de outros aparelhos da marca, como iPad e iPod, inclusive com anotações ou destaques criadas pelo usuários. Parece que Jobs preocupa-se em integrar seus produtos.

Outra novidade desta versão do sistema operacional é o iBooks. Este aplicativo deve ser disponibilizado gratuitamente na loja virtual da Apple e vai mexer com o mercado de e-books. Segundo a desenvolvedora, o iBooks consegue sincronizar livros digitais de outros aparelhos da marca, como iPad e iPod, inclusive com anotações ou destaques criadas pelo usuários. Parece que Jobs preocupa-se em integrar seus produtos.

Quanto custa?

Não está aguentando de curiosidade para saber o preço dessa novidade, não é mesmo? Então vamos ao que interessa. O iPhone 4 deve ser comercializado nas cores branca ou preta por US$ 199 para o modelo com 16 GB e US$ 299 com 32 GB. Ele estará à venda, a partir do dia 24 de junho, nos EUA, Alemanha, Japão e Reino Unido.

Quer encomendar o seu? Então fique ligado, pois dia 15 de junho é a data em que a Apple Store começará a reservar os aparelhos. Com isso, as versões anteriores devem sofrer reduções de preço: o iPhone 3GS com 8 GB deve ser vendido por US$ 99, por exemplo.

Como Steve Jobs não abre mão de manter sua empresa como um símbolo de inovação e crescimento, mais novidades surgiram na Worldwide Developers Conference (WWDC) 2010 - evento focado em desenvolvedores da plataforma Apple.

Não podiamos ficar fora dessa e acompanhaos tudo que rolou na conferência que contou com mais de 5200 participantes de 57 países e aconteceu neste dia 7 de junho. Confira as informações e novidades que acabaram de sair do forno!

As vendas do iPad

Para os céticos que tinham o iPad como um aparelho fadado a decadência e que não passaria de um iPhone grande, Jobs começou sua apresentação passando alguns dados interessantes. O mais significativo é que a cada 3 segundos um iPad é vendido.

Aparentemente, as funcionalidades e novidades do aparelho tiveram uma ótima aceitação do mercado. Ou será que a Apple é apenas uma empresa perita em marketing de venda? Fato é que o CEO da organização está satisfeito e contente com o resultado do iPad. Segundo ele, os conceitos e visões gerais da empresa mudaram com o desenvolvimento desta tecnologia.

Uma das grandes reclamações no lançamento do iPad foi a quantidade de aplicativos disponíveis na loja virtual da empresa. A difusão do aparelho aumentou a preocupação da Apple com esse contexto, e a empresa buscou aprimorar sua App Store.

Hoje, ela conta com 8500 aplicativos para o modelo, os quais registraram cerca de 35 milhões de aquisições (aproximadamente 17 aplicativos por iPad). Essa foi mais uma ação para aproximar a marca de seus clientes.

iPhone 4

Eis que um dos lançamentos mais esperados pelos aficionados em tecnologia, finalmente, aconteceu: o iPhone 4 foi anunciado. O aparelho sofreu, de acordo com Steve Jobs, 100 reformulações, as quais devem agradar aqueles que priorizam qualidade de captação e reprodução de imagens, vida útil da bateria e dimensionamento reduzido.

O tamanho do iPhone já foi criticado por muita gente: alguns acham incômodo segurá-lo. Se essa era um motivo para não comprá-lo, pode esquecer. A nova versão do aparelho tem 9,3 milímetros de espessura (24% mais fino que o 3GS) e entra na briga entre os smartphones mais finos do mundo.

O design do iPhone também foi renovado. Além da redução de espessura, foram implementados vidros de alta resistência, tanto na frente como atrás do aparelho; aço inoxidável recobrindo os detalhes laterais; controles de volume; saída para fones; e entrada para cartões SIM. Confira no vídeo seguinte a aparência da novidade:

Capacidade visual

A qualidade na exibição de imagens foi outro ponto que sofreu melhorias. Segundo o que foi apresentado na WWDC 2010, o iPhone 4 conta com uma nova tecnologia, chamada de Retina Display (em uma tradução livre, "Exibição de Retina"). Com essa novidade, o aparelho deve apresentar 326 pixels por polegada - 26 a mais do que a retina humana suporta -, o que proporciona maior nitidez das imagens e facilita a leitura de textos.

Câmeras

A capacidade de capturar imagens e vídeos do iPhone sempre foi um motivo de descrença na potencialidade do aparelho. Mais uma vez, a Apple buscou eliminar qualquer característica que tenha sofrido críticas. Nesta versão foi acrescentada uma câmera na parte frontal do smartphone, possibilitando a comunicação através de videoconferências.

Por sua vez, a câmera na parte traseira ganhou potência. Agora ela possui 5 mega pixels, zoom digital de 5 vezes e flash em LED. Dessa forma o iPhone suporta, também, gravar vídeos em alta definição (aqueles com 720p). Aliada à Retina Display, esta câmera deve surpreender na qualidade de fotos e filmagens.

O processamento de dados do iPhone 4 utiliza mais uma inovação da Apple: o chip A4. Pôde-se perceber, durante a apresentação na conferência, que a maior vantagem desta tecnologia é o tempo de vida útil da bateria.

Segundo os dados exibidos, o smartphone chega a operar em standby por 300 horas e em conversação por sete. Para aqueles que gostam de escutar suas bandas e cantores prediletos, uma informação animadora: são 40 horas de música sem parar!

Mais realidade aos jogos

Os gamers mais exigentes devem curtir a união entre as tecnologias no iPhone 4. O giroscópio conta com três eixos de movimentos na representação dos jogos. Entretanto, ao ser combinado com o potente acelerômetro do aparelho, o número de eixos passa para seis.

Enfim, multitarefas

O iPhone 4 tem todas as suas funcionalidades gerenciadas pelo sistema operacional IOS 4. Este lançamento da Apple proporciona que o usuário utilize vários aplicativos ao mesmo tempo, as denominadas multitarefas - característica amplamente criticada e que fez falta nos modelos anteriores.

A personalização do SO ficou mais flexível, possibilitando a alteração do plano de fundo em telas de bloqueio, por exemplo. A mobilidade e a renomeação de arquivos devem ser outros fatores muito práticos no IOS 4. Com ele, alterar o nome de uma pasta ou mover um documento para outro local é descomplicado e intuitivo.

Quanto custa?

Não está aguentando de curiosidade para saber o preço dessa novidade, não é mesmo? Então vamos ao que interessa. O iPhone 4 deve ser comercializado nas cores branca ou preta por US$ 199 para o modelo com 16 GB e US$ 299 com 32 GB. Ele estará à venda, a partir do dia 24 de junho, nos EUA, Alemanha, Japão e Reino Unido.

Quer encomendar o seu? Então fique ligado, pois dia 15 de junho é a data em que a Apple Store começará a reservar os aparelhos. Com isso, as versões anteriores devem sofrer reduções de preço: o iPhone 3GS com 8 GB deve ser vendido por US$ 99, por exemplo.

sexta-feira, 4 de junho de 2010

Televisão versus Internet: Qual você prefere?

Poucos meios de comunicação transformaram tanto o mundo quanto a televisão e a internet. Enquanto a primeira proporcionou um novo jeito de olhar o mundo desde a metade do século passado, a internet mudou a forma de as pessoas se comunicarem, rompendo barreiras e tornando qualquer ponto do planeta próximo em questão de segundos.

Opções, tanto em uma quanto em outra, não faltam. Enquanto a televisão é o meio de comunicação com maior número de usuários e maior impacto sobre a população brasileira, a internet além do entretenimento é capaz de servir também como uma ferramenta de trabalho.

Hoje, é impossível imaginar o mundo sem as duas tecnologias. No entanto, embora complementares, ambas concorrem diretamente na preferência do público. Em função de qual delas você passa mais tempo? Qual das duas é mais importante em sua vida?

Colocamos duas grandes armas frente a frente num ringue e levantou os principais pontos positivos e negativos de cada uma. Televisão versus internet, qual das duas sairá vencedora deste embate?

No canto esquerdo do ringue está a quase centenária televisão. Surgido na década de 20, o aparelho bateu de frente com o rádio e acabou se popularizando no mundo todo a partir da década de 50. Até meados do ano 2000 tudo o que de mais importante aconteceu no mundo chegou aos espectadores por meio da telinha da TV.

Embora tenha perdido parte de sua popularidade com a chegada da internet, a televisão ainda hoje reina absoluta nos lares brasileiros, chegando a nada menos que 99% da população. Com novas tecnologias e telas cada vez maiores e com maior definição, o meio é um concorrente de peso na preferência do espectador.

Do outro lado do ringue está a cada vez mais onipresente internet. Nascida na década de 90, a rede mundial de computadores foi a grande responsável por uma verdadeira revolução no mundo das comunicações. Com ela qualquer usuário atravessa o planeta em questão de segundos com apenas um clique.

Do outro lado do ringue está a cada vez mais onipresente internet. Nascida na década de 90, a rede mundial de computadores foi a grande responsável por uma verdadeira revolução no mundo das comunicações. Com ela qualquer usuário atravessa o planeta em questão de segundos com apenas um clique.

Junto com o seu crescimento a internet também trouxe novos serviços, como transmissão de áudio, vídeo, games, livros e uma quantidade tão grande de conteúdo que seria impossível acessar em vida a tudo o que já existe disponível sobre determinados assuntos. Os lutadores se aproximam, soa o gongo e começa o embate!

Durante muitos anos a televisão foi praticamente a única maneira pela qual os usuários podiam ver, em tempo real, as novidades que estavam acontecendo do outro lado do mundo. A chegada do homem à Lua, as grandes transmissões esportivas, a queda do muro de Berlim e a guerra no Iraque foram apenas alguns dos eventos que mobilizaram multidões diante dos aparelhos.

Porém, quase 20 anos depois da chegada da internet o panorama mudou completamente. A notícia que antes chegava em primeira mão pela televisão agora aparece em tempo real e é emitida pelos próprios usuários, por meio das muitas redes sociais e serviços de microblog existentes.

A quantidade de conteúdo disponível online é imensurável. Hoje em dia é possível achar informações sobre qualquer assunto, com direito a multiplicidade de fontes e possibilidade de entrar em contato direto com o autor para esclarecer dúvidas ou mesmo iniciar um debate.

Já a TV apostou em outro caminho. Com as emissoras de TV aberta oferecendo um misto de entretenimento e resumo do que de mais importante acontece, a aposta foi segmentar a audiência, em especial nas TVs a cabo. Assim temos hoje programas para nichos específicos de público, como fazendeiros, estilistas, cinéfilos ou religiosos.

Por mais simples que seja, um programa de televisão necessita de uma produção maior. Cinegrafista, estúdio, ilha de edição e profissionais que se expressem bem no vídeo são apenas alguns dos pré-requisitos para levar um programa ao ar. Tanta preocupação acaba resultando em melhor qualidade de imagem e um produto mais agradável de ser visto.

Por outro lado, na televisão o tempo ainda é um grande inimigo. Ver um determinado conteúdo na hora em que bem entender ainda é uma opção para poucos usuários. Por ser mais abrangente, as informações passadas na televisão precisam necessariamente ser mais didáticas - o que resulta em assuntos abordados de maneira mais superficial.

A internet, por outro lado, funciona como um grande banco de dados em que o espectador pode acessar, à hora em que bem entender, a programação que deseja. Além disso, caso necessite, poderá fazer uma pausa quando quiser e retomar um vídeo, um texto ou uma entrevista em áudio do ponto em que parou.

A simplicidade de transmissão da web faz com que qualquer usuário com uma webcam, por exemplo, transmita em tempo real informações para um público específico. O custo operacional da web é menor. No entanto, em termos de qualidade de imagem, o resultado final oferecido pela televisão ainda é superior.

Na prática, é possível assistir à programação de televisão tanto na internet quanto no seu aparelho de TV. Porém a diferença é que no primeiro caso é preciso que você tenha um conhecimento básico de informática para chegar até um aplicativo do gênero, executá-lo e selecionar a emissora.

Já no caso do aparelho de TV tudo o que o usuário precisa fazer é apertar um botão para ligar. A praticidade da televisão em relação à internet é um fator determinante para que usuários, em especial aqueles sem condições de pagar pelo acesso ou que não possuem um conhecimento restrito em internet, nem sequer cogitem a rede mundial de computadores como concorrente.

Da mesma forma, a televisão do futuro deverá trazer entre as suas opções a possibilidade de o usuário acessar a internet a partir do controle remoto. A experiência deve tornar a web muito mais intuitiva e próxima do cotidiano do público não familiarizado com a rede.

Com isso, além da programação de TV aberta e a cabo, será possível conferir o conteúdo de emissoras do mundo todo e, inclusive, de emissoras criadas por usuários. A variedade de canais deixará de ser uma exclusividade do computador e passará a figurar no aparelho de TV da sala.

Uma das principais características que contribui para o avanço da internet foi a maneira com que a programação ou o conteúdo eram apresentados para o público. Ao invés de o espectador ficar à mercê daquilo que uma emissora julga conveniente, o próprio usuário escolhe o que quer ver quando bem entender.

Isso, no entanto, mudou bastante nos últimos anos. Muitas emissoras já permitem que o usuário escolha quais programas deseja ver e na hora que bem entender. No entanto esse recurso é limitado e o espectador ainda assim fica refém da seleção de conteúdos que o canal apresenta.

Os próximos aparelhos de TV devem ganhar a internet como aliada e, a partir do controle remoto, p/ usuário acessará seus sites favoritos e visualizará o mesmo conteúdo disponível no computador. A diferença fica por conta da mobilidade, afinal ninguém vai sair por aí carregando um aparelho de TV.

Já na internet as possibilidades são praticamente infinitas. Além de escolher a quais vídeos assistir, sobre os mais variados assuntos, é possível ainda comentar, editar, compartilhar o conteúdo com amigos e, em alguns casos, tornar-se parte do assunto, como nas transmissões via streaming.

A questão do custo é ainda um dos maiores diferenciais em prol das televisões. É possível comprar um aparelho simples por menos de R$ 500. Além disso, a programação da TV aberta oferece ao menos uma dezena de canais sem custo algum.

Para aqueles que desejarem mais opções em emissoras, as operadoras de TV por assinatura oferecem pacotes a partir de R$ 30 mensais. Some-se a isso o fato que para ligar um televisor não é preciso ter conhecimento técnico nenhum e o resultado é o meio de comunicação mais influente no país.

Já com a internet a situação não é tão simples. Antes de tudo é preciso adquirir um computador de qualidade razoável, algo que não sai por menos de R$ 800. O acesso até pode ser feito via internet discada, no entanto a qualidade fica seriamente comprometida.

Os planos de banda larga ainda não alcançam todas as cidades do país e mesmo nas grandes capitais há regiões não contempladas pelo cabeamento. A internet 3G é uma opção, porém seu custo é mais elevado, tornando-a inacessível para boa parte da população.

Finalmente, ligar um computador e procurar pela programação desejada requer um conhecimento básico de informática, algo que ainda não é realidade para muitos no país.

E você, caro leitor, para qual dos lados daria a vitória neste combate? Você prefere internet ou televisão? Participe deixando a sua opinião nos comentários.

Via: Baixaki

Opções, tanto em uma quanto em outra, não faltam. Enquanto a televisão é o meio de comunicação com maior número de usuários e maior impacto sobre a população brasileira, a internet além do entretenimento é capaz de servir também como uma ferramenta de trabalho.

Hoje, é impossível imaginar o mundo sem as duas tecnologias. No entanto, embora complementares, ambas concorrem diretamente na preferência do público. Em função de qual delas você passa mais tempo? Qual das duas é mais importante em sua vida?

Colocamos duas grandes armas frente a frente num ringue e levantou os principais pontos positivos e negativos de cada uma. Televisão versus internet, qual das duas sairá vencedora deste embate?

Conhecendo os lutadores

Embora tenha perdido parte de sua popularidade com a chegada da internet, a televisão ainda hoje reina absoluta nos lares brasileiros, chegando a nada menos que 99% da população. Com novas tecnologias e telas cada vez maiores e com maior definição, o meio é um concorrente de peso na preferência do espectador.

Junto com o seu crescimento a internet também trouxe novos serviços, como transmissão de áudio, vídeo, games, livros e uma quantidade tão grande de conteúdo que seria impossível acessar em vida a tudo o que já existe disponível sobre determinados assuntos. Os lutadores se aproximam, soa o gongo e começa o embate!

Round 1: variedade

Durante muitos anos a televisão foi praticamente a única maneira pela qual os usuários podiam ver, em tempo real, as novidades que estavam acontecendo do outro lado do mundo. A chegada do homem à Lua, as grandes transmissões esportivas, a queda do muro de Berlim e a guerra no Iraque foram apenas alguns dos eventos que mobilizaram multidões diante dos aparelhos.

Porém, quase 20 anos depois da chegada da internet o panorama mudou completamente. A notícia que antes chegava em primeira mão pela televisão agora aparece em tempo real e é emitida pelos próprios usuários, por meio das muitas redes sociais e serviços de microblog existentes.

A quantidade de conteúdo disponível online é imensurável. Hoje em dia é possível achar informações sobre qualquer assunto, com direito a multiplicidade de fontes e possibilidade de entrar em contato direto com o autor para esclarecer dúvidas ou mesmo iniciar um debate.

Já a TV apostou em outro caminho. Com as emissoras de TV aberta oferecendo um misto de entretenimento e resumo do que de mais importante acontece, a aposta foi segmentar a audiência, em especial nas TVs a cabo. Assim temos hoje programas para nichos específicos de público, como fazendeiros, estilistas, cinéfilos ou religiosos.

Round 2: qualidade

Por mais simples que seja, um programa de televisão necessita de uma produção maior. Cinegrafista, estúdio, ilha de edição e profissionais que se expressem bem no vídeo são apenas alguns dos pré-requisitos para levar um programa ao ar. Tanta preocupação acaba resultando em melhor qualidade de imagem e um produto mais agradável de ser visto.

Por outro lado, na televisão o tempo ainda é um grande inimigo. Ver um determinado conteúdo na hora em que bem entender ainda é uma opção para poucos usuários. Por ser mais abrangente, as informações passadas na televisão precisam necessariamente ser mais didáticas - o que resulta em assuntos abordados de maneira mais superficial.

A internet, por outro lado, funciona como um grande banco de dados em que o espectador pode acessar, à hora em que bem entender, a programação que deseja. Além disso, caso necessite, poderá fazer uma pausa quando quiser e retomar um vídeo, um texto ou uma entrevista em áudio do ponto em que parou.

A simplicidade de transmissão da web faz com que qualquer usuário com uma webcam, por exemplo, transmita em tempo real informações para um público específico. O custo operacional da web é menor. No entanto, em termos de qualidade de imagem, o resultado final oferecido pela televisão ainda é superior.

Round 3: facilidade de acesso

Na prática, é possível assistir à programação de televisão tanto na internet quanto no seu aparelho de TV. Porém a diferença é que no primeiro caso é preciso que você tenha um conhecimento básico de informática para chegar até um aplicativo do gênero, executá-lo e selecionar a emissora.

Já no caso do aparelho de TV tudo o que o usuário precisa fazer é apertar um botão para ligar. A praticidade da televisão em relação à internet é um fator determinante para que usuários, em especial aqueles sem condições de pagar pelo acesso ou que não possuem um conhecimento restrito em internet, nem sequer cogitem a rede mundial de computadores como concorrente.

Da mesma forma, a televisão do futuro deverá trazer entre as suas opções a possibilidade de o usuário acessar a internet a partir do controle remoto. A experiência deve tornar a web muito mais intuitiva e próxima do cotidiano do público não familiarizado com a rede.

Com isso, além da programação de TV aberta e a cabo, será possível conferir o conteúdo de emissoras do mundo todo e, inclusive, de emissoras criadas por usuários. A variedade de canais deixará de ser uma exclusividade do computador e passará a figurar no aparelho de TV da sala.

Round 4: interatividade

Uma das principais características que contribui para o avanço da internet foi a maneira com que a programação ou o conteúdo eram apresentados para o público. Ao invés de o espectador ficar à mercê daquilo que uma emissora julga conveniente, o próprio usuário escolhe o que quer ver quando bem entender.

Isso, no entanto, mudou bastante nos últimos anos. Muitas emissoras já permitem que o usuário escolha quais programas deseja ver e na hora que bem entender. No entanto esse recurso é limitado e o espectador ainda assim fica refém da seleção de conteúdos que o canal apresenta.

Os próximos aparelhos de TV devem ganhar a internet como aliada e, a partir do controle remoto, p/ usuário acessará seus sites favoritos e visualizará o mesmo conteúdo disponível no computador. A diferença fica por conta da mobilidade, afinal ninguém vai sair por aí carregando um aparelho de TV.

Já na internet as possibilidades são praticamente infinitas. Além de escolher a quais vídeos assistir, sobre os mais variados assuntos, é possível ainda comentar, editar, compartilhar o conteúdo com amigos e, em alguns casos, tornar-se parte do assunto, como nas transmissões via streaming.

Round 5: custos

A questão do custo é ainda um dos maiores diferenciais em prol das televisões. É possível comprar um aparelho simples por menos de R$ 500. Além disso, a programação da TV aberta oferece ao menos uma dezena de canais sem custo algum.